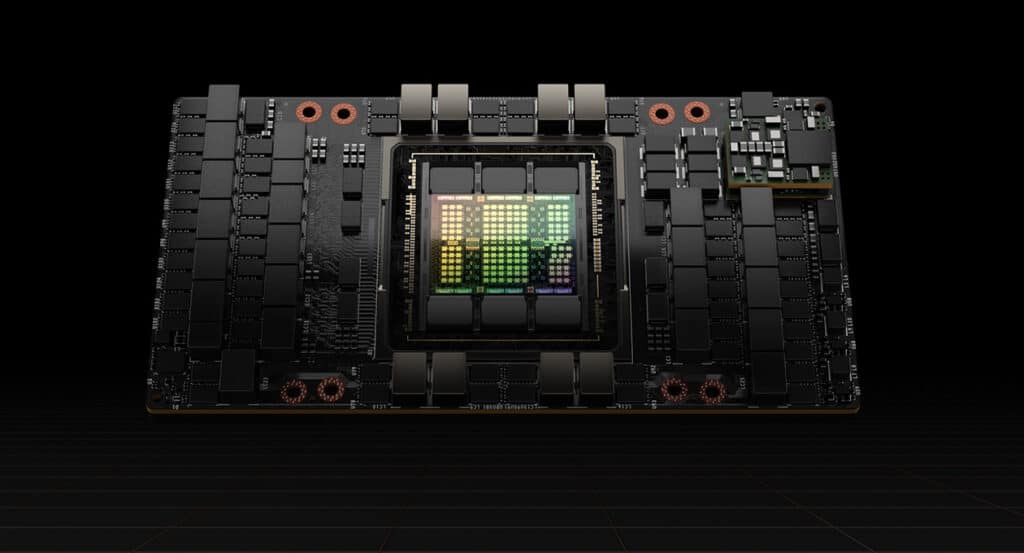

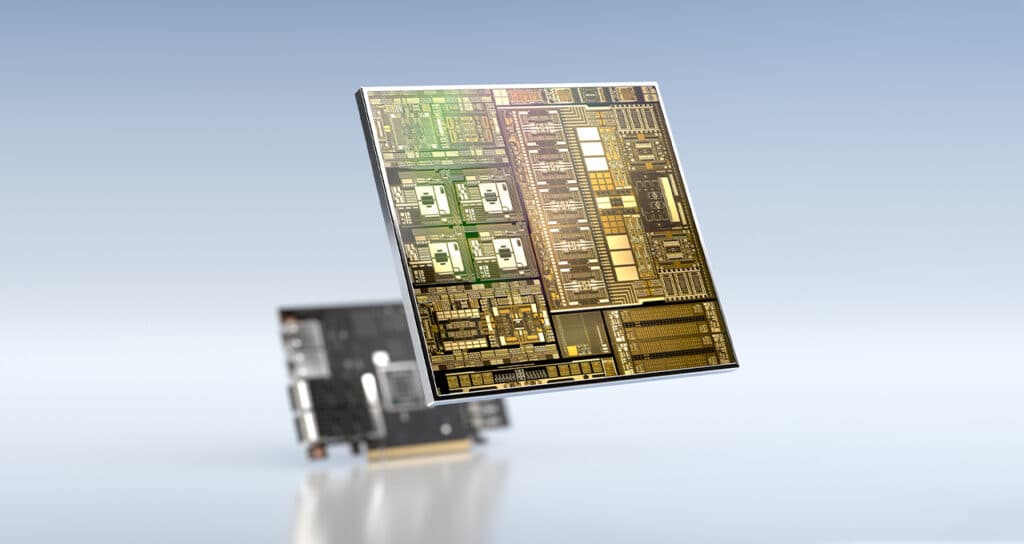

Nvidia's erste Accelerated-Computing-Plattform mit Nvidia Hopper™-Architektur

NVIDIA hat auf der Frühjahrs-GTC’22 im März 2022 ihre neue Hopper-Architektur angekündigt. Sie stellt, lt. NVIDIA, die nächste Generation von beschleunigtem Computing mit beispielloser Leistung, Skalierbarkeit und Sicherheit für jedes Rechenzentrum dar. Erstmals wird die Hopper-Architektur in den H100 GPUs von NVIDIA zu finden sein.

Besonderheiten der NVIDIA H100 GPU

- Die neuen H100 GPUs sind die ersten Hopper-basierte Grafikprozessoren, die mit 80 Milliarden Transistoren ausgestattet sind.

- Er gilt bereits jetzt als der größte und leistungsstärkste Beschleuniger (Accelerator) der Welt und verfügt über leistungsstarke Funktionen wie die Transformer Engine und einen hoch-skalierbaren NVIDIA NVLink® Interconnect für die Entwicklung großer KI-Sprachmodelle, tiefgreifender Recommender-Systemen, Genomik und komplexer digitaler Zwillinge.

„Rechenzentren werden zu KI-Fabriken, die Berge von Daten verarbeiten und veredeln, um Intelligenz zu erzeugen“, sagt Jensen Huang, Gründer und CEO von NVIDIA. Er fügt hinzu: „NVIDIA H100 ist der Motor der weltweiten KI-Infrastruktur, die Unternehmen nutzen, um ihre KI-getriebenen Geschäfte zu beschleunigen.“

Kernelemente der H100 Technologie

Laut NVIDIA setzt der NVIDIA H100 Grafikprozessor einen neuen Standard bei der Beschleunigung von KI und HPC. Dieser wird durch sechs bahnbrechende Innovationen erreicht:

- Fortschrittlicher Chip

Die H100 GPU unterstützt erstmalig PCIe Gen5 und nutzt als erste GPU HBM3. Es wird eine Speicherbandbreite von 3 TB/s ermöglicht.

- Transformer Engine

Der Transformer gehört zu den Standardmodellen für die Verarbeitung von Sprachbefehlen und ist eines der wichtigsten Deep-Learning-Modelle, die je entwickelt wurden. Die Transformer-Engine des H100-Accelerator soll, lt. NVIDIA, Netzwerke um das 6-fache beschleunigen als vorherige Generationen, ohne dabei an Genauigkeit zu verlieren. - Sichere Multi-Instanz-GPU der 2. Generation

Die Hopper-Architektur erweitert die Multi-Instanz-GPU-Fähigkeiten um das bis zu 7-fache im Vergleich zur vorherigen Generation. Sie ermöglicht eine sichere, mandantenfähige Konfiguration in Cloud-Umgebungen über jede GPU-Instanz. - Confidential Computing

H100 ist der weltweit erste Beschleuniger mit vertraulichen Datenverarbeitungsfunktionen zum Schutz von KI-Modellen und Kundendaten während ihrer Verarbeitung. Kunden können auch vertrauliches Computing für föderiertes Lernen in datenschutzsensiblen Branchen wie dem Gesundheitswesen und Finanzdienstleistungen sowie auf gemeinsam genutzten Cloud-Infrastrukturen einsetzen.

- NVIDIA NVLink der 4. Generation

Um die größten KI-Modelle zu beschleunigen, wird NVLink mit einem neuen externen NVLink Switch kombiniert, um NVLink als skalierbares Netzwerk über den Server hinaus zu erweitern und bis zu 256 H100 GPUs mit 9-fach höherer Bandbreite im Vergleich zur vorherigen Generation mit NVIDIA HDR Quantum InfiniBand zu verbinden. - DPX Befehle zur Beschleunigung dynamischer Programmierung

Mit der NVIDIA Hoopper GPU-Architektur kann die dynamische Programmierung mittels DPX-Befehlen um das bis zu 40-fache beschleunigt werden. Mit dem neuen Befehlssatz sind Entwickler in der Lage einen Code zu schreiben, um Geschwindigkeitssteigerungen bei dynamischen Programmieralgorithmen zu erzielen, beispielsweise für Routenoptimierungen nach dem Floyd-Warshall-Algorithmus oder für die Erbgutanalyse (Smith-Waterman-Algorithmus).

Einsatzgebiete der NVIDIA H100

NVIDIA H100 kann in jeder Art von Rechenzentrum eingesetzt werden, einschließlich On-Premises, Cloud, Hybrid-Cloud und Edge.

NVIDIA H100

Der H100 wird in den Formfaktoren SXM und PCIe erhältlich sein, um eine breite Palette von Serverdesignanforderungen zu unterstützen.

Darüber hinaus wird ein konvergierter Beschleuniger (Converged Accelerator), der H100 CNX, erhältlich sein, der einen H100 Grafikprozessor mit einer NVIDIA ConnectX®-7 400Gb/s InfiniBand und Ethernet SmartNIC kombiniert.

- H100 SXM wurde für Unternehmen in HGX™ H100 Server-Boards mit 4- und 8-Wege-Konfigurationen angekündigt, deren Anwendungen auf mehrere GPUs in einem Server und über mehrere Server skalieren. Lt. NVIDIA liefern HGX H100-basierte Server die höchste Anwendungsleistung für KI-Training und -Inferenz sowie Datenanalyse und HPC-Anwendungen.

- H100 PCIe mit NVLink bietet einen Anschluss für zwei GPUs und mehr als die 7-fache Bandbreite von PCIe 5.0, lt. NVIDIA. Damit ist er speziell für Anwendungen geeignet, die auf Mainstream-Unternehmensservern laufen. Durch den Formfaktor ist er leicht in bestehende Infrastrukturen von Rechenzentren zu integrieren.

- H100 CNX Accelerator ist ein neuer Converged Accelerator. Er kombiniert eine H100 mit einer ConnectX-7 SmartNIC, um eine herausstechende Leistung für I/O-intensive Anwendungen wie Multinode-KI-Trainings in großen Enterprise Data Center und 5G-Signalverarbeitung am Edge zu bieten.

Auf der NVIDIA Hopper-Architektur basierende Grafikprozessoren können auch mit NVIDIA Grace™-CPUs mit einem ultraschnellen NVLink-C2C-Interconnect für eine über 7x schnellere Kommunikation zwischen CPU und GPU im Vergleich zu PCIe 5.0 kombiniert werden. Diese Kombination – der Grace Hopper Superchip – ist ein integriertes Modul, das für sehr große HPC- und KI-Anwendungen entwickelt wurde.

Grace CPU: Superchip: Mit dem Grace CPU Superchip können Kunden eine 10-fach schnellere Zeit bis zur Lösung mit der beschleunigten Grace Hopper CPU erzielen, die für HPC- und KI-Anwendungen im Giant-Scale-Format entwickelt wurde.

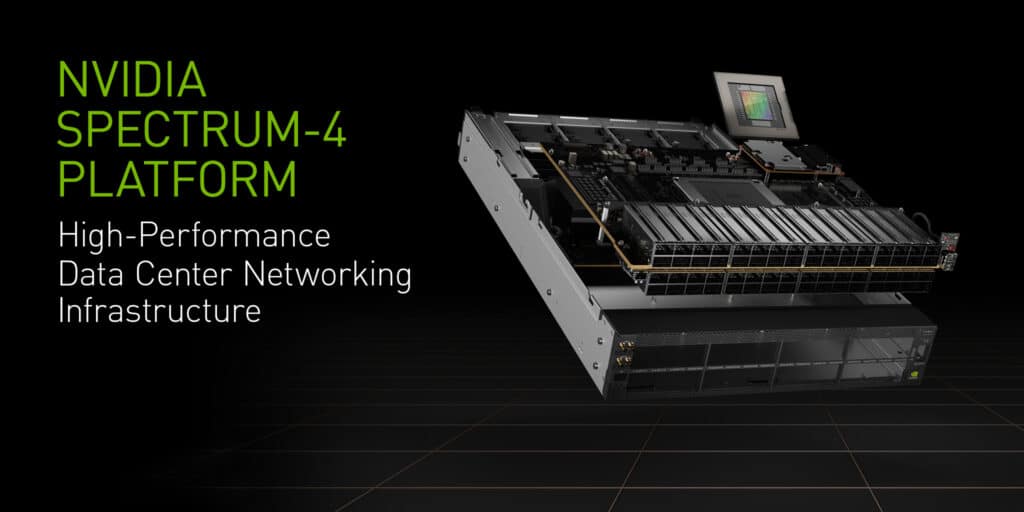

Produkt-Ankündigungen im Netzwerk-Bereich (Spectrum-4 und Bluefield)

NVIDIA Spectrum-4, DER51, 2 TB/S-Ethernet-Switch-Asic

Der NVIDIA Spectrum-4 ASIC und die SN5000 Switch-Familie bilden die bisher innovativste Ethernet-Plattform von NVIDIA, die auf einem 5-nm-Prozess basiert und über 100 Milliarden Transistoren enthält.

Mit einer ASIC-Gesamtbandbreite von 51,2 Tbit/s, die Port-Geschwindigkeiten von 400 und 800 GbE ermöglicht, und adaptiven Routing-Protokollen bietet Spectrum-4 die Leistung und Sicherheit, die für modernste Rechenzentren erforderlich sind.

Darüber hinaus beschleunigen und vereinfachen die Spectrum-4-Innovationen Anwendungen aus einer Vielzahl von Branchen, darunter Cloud-, Storage-, Artificial Intelligence-, Deep Learning- und 5G-Lösungen. Spectrum-4 ist auch auf NVIDIA Air für die Simulation von Rechenzentrumsinfrastrukturen bis hin zur ASIC-Ebene verfügbar.

Ideale Einsatzgebiete sind:

- Öffentliche Cloud (XaaS)

- Private Cloud

- DGX / Ethernet Storage Fabric (ESF) (durch Breakout-Kabel, die dichte 200/400G an den Knoten liefern)

NVIDIA Bluefield-3 DPU

Die NVIDIA BlueField-3 DPU ist die weltweit fortschrittlichste Rechenzentrumsinfrastruktur auf einem Chip und bietet softwaredefinierte, hardwarebeschleunigte Netzwerk-, Speicher-, Sicherheits- und Verwaltungsdienste mit 400 Gb/s.

BlueField-3 entlastet, beschleunigt und isoliert die Infrastruktur des Rechenzentrums von den Geschäftsanwendungen und verwandelt herkömmliche Computerumgebungen in effiziente, leistungsstarke und vertrauenswürdige Rechenzentren, von der Cloud über den Core bis zum Edge.

Das NVIDIA DOCA SDK bietet Industriestandard-APIs und ein optimiertes Entwicklererlebnis und schützt die Investitionen und Verpflichtungen in DPU-beschleunigte Anwendungen und Dienste, indem es eine zukunftssichere Laufzeitumgebung ermöglicht, wenn sich die DPU-Generationen weiterentwickeln.

In Kombination mit NVIDIA-GPUs ermöglicht BlueField-3 moderne, Cloud-native Rechenzentrumsplattformen für das Zeitalter der KI.

SIE MÖCHTEN MEHR ZU DEN NEUEN NVIDIA PRODUKTEN VON DER GTC’22 ERFAHREN ODER HABEN IDEALE EINSATZFELDER, WO DIESE PASSEN KÖNNTEN?

Rufen Sie uns einfach an. Wir finden die passende Lösung für Ihren Bedarf.