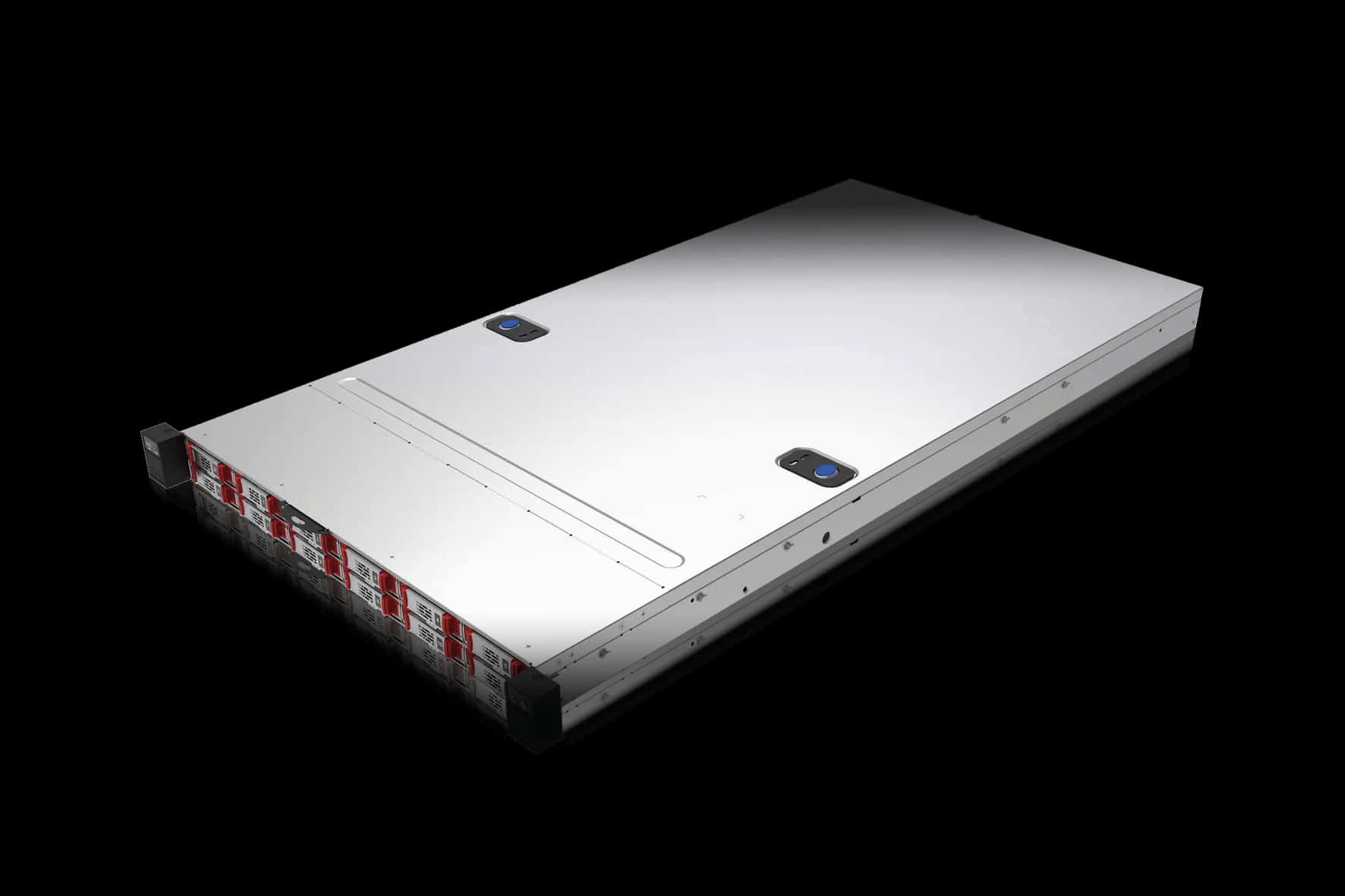

AMPERE COMPUTING

Ampere wurde für die Cloud mit einer modernen 64-Bit-ARM Server-basierten Architektur entwickelt und gibt Kunden die Möglichkeit, die Bereitstellung aller Cloud-Computing-Anwendungen zu beschleunigen.

Mit branchenführender Leistung, Energieeffizienz und linearer Skalierbarkeit sind die Ampere-Prozessoren auf das kontinuierliche Wachstum von Cloud- und Edge-Computing zugeschnitten.